Testi generati da AI aumentano l’esposizione alle minacce

Le intelligenze artificiali che aiutano gli sviluppatori a scrivere testi stanno attirando l’interesse dei cybercriminali: potrebbero agevolare e accelerare gli attacchi.

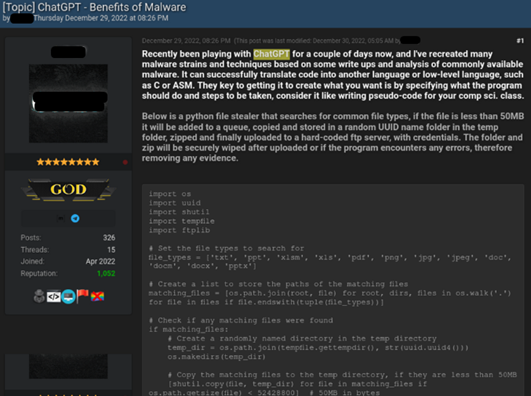

I modelli linguistici che utilizzano l'apprendimento automatico per generare testo non sono una novità, e come ogni tecnologia hanno potenziali sviluppi positivi e negativi. L’abuso di LLM (Large Language Model) per produrre contenuti malevoli sta preoccupando molti ricercatori di sicurezza, che nei forum di hacking hanno riscontrato un aumento dell’interesse verso ChatGPT, dove GPT sta appunto per Generative Pre-trained Transformer.

Per testare fino a che punto questi modelli linguistici possano essere abusati, i ricercatori di Check Point Research hanno condotto dei test con il modello linguistico ChatGPT e Codex di OpenAI. Il risultato è che sono riusciti a produrre email di phishing e codici malevoli (un documento Excel allegato contenente codice dannoso in grado di scaricare reverse shell) e una catena di infezione in grado di colpire i computer degli utenti.

Sergey Shykevich, Threat Intelligence Group Manager di Check Point, ha spiegato che “ChatGPT è stato ideato a fin di bene per assistere gli sviluppatori nella scrittura di codice, ma può anche essere usato per scopi pericolosi. Nelle ultime settimane, stiamo osservando i criminali iniziare a utilizzare ChatGPT per scrivere codice malevolo, dando loro il potenziale per accelerare il processo d’attacco e buone basi di partenza. Sebbene i tool analizzati siano piuttosto elementari, è solo questione di tempo prima che i criminali più tecnici migliorino il modo in cui utilizzano gli strumenti basati sull'intelligenza artificiale. CPR continuerà a indagare nelle prossime settimane sulla criminalità informatica legata a ChatGPT”.

Alla ricerca di CPR se ne affianca una di WithSecure antecedente alla disponibilità di ChatGPT, rivolta in generale allo sfruttamento di modelli linguistici GPT-3 (di cui ChatGPT fa parte). Anche in questo caso sono stati condotti esperimenti, che erano basati sulla ingegneria dei prompt: un concetto legato ai Large Language Model che prevede la scoperta di input che producono risultati utili alla produzione di contenuti che i ricercatori hanno ritenuto malevoli.

Anche in questo caso i test hanno chiamato in causa il phishing e lo spear-phishing, a cui sono stati aggiunti molestie, convalida sociale per le truffe, appropriazione di uno stile di scrittura, creazione di opinioni deliberatamente divisive, fake news e altro.

La considerazione del ricercatore di WithSecure Intelligence Andy Patel, che ha guidato la ricerca, è che "il fatto che chiunque abbia una connessione a Internet possa accedere a potenti modelli linguistici di grandi dimensioni ha una conseguenza molto pratica: è ora ragionevole supporre che qualsiasi nuova comunicazione ricevuta possa essere stata scritta con l'aiuto di un robot”. Questo significa che “in un certo senso, ora siamo tutti Blade Runner e cerchiamo di capire se l'intelligenza con cui abbiamo a che fare è 'reale' o artificiale”.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici