AI: tre scenari di attacco preoccupanti

Fino a che punto l’Intelligenza Artificiale può agevolare un attacco cyber? La risposta in tre possibili scenari proposti da un esperto di CyberArk.

L'Intelligenza Artificiale sta trasformando la società a una velocità senza precedenti. L’AI può fare i compiti, aiutare a migliorare gli investimenti e molto altro. In ambito cybersecurity è chiaro da tempo che si tratta di uno strumento indispensabile sia per la difesa sia per l’attacco. In quest’ultimo frangente, di recente l’attenzione è coalizzata da ChatGPT, tuttavia ci sono opportunità di attacco decisamente meno esotiche ma altrettanto pericolose. Ne dà una chiara idea Lavi Lazarovitz, Head of Security Research dei Cyberark Labs in un interessante post sul blog ufficiale dell’azienda, dove propone tre scenari tipo di attacchi cyber che sfruttano l’AI: vishing, autenticazione biometrica e malware polimorfo.

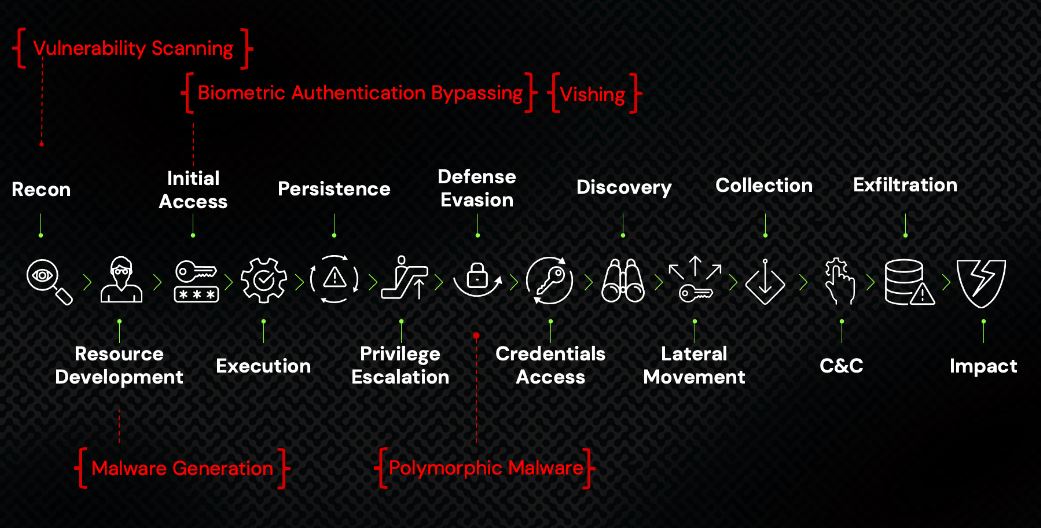

Sono un chiaro esempio del fatto che se da una parte è vero che l'IA sta contaminando gli attacchi cyber, dall’altra quasi ogni attacco continua a seguire una modulazione familiare descritta nel framework MITRE ATT&CK for Enterprise, che inizia con la compromissione dell'identità.

Lo scenario del vishing

Il termine vishing identifica le campagne di phishing operate tramite telefono o messaggio vocale. Nello scenario proposto da Lazarovitz il CEO di un’azienda lascia al dipendente-vittima un messaggio vocale via WhatsApp in cui si sente la sua voce distinta chiedere un immediato trasferimento di denaro. C’è addirittura una fase di interazione in cui il dipendente perplesso chiede maggiori delucidazioni e il CEO risponde con tutti i dettagli necessari.

Che cos’è successo? L’attacco è stato preparato dando in pasto all’AI interventi pubblici e interviste ai media tenute dal CEO. La voce, studiata dal computer, è stata copiata e usata per impersonare lo stesso CEO. Quello che ne risulta sono veri e propri deep fake basati sull'Intelligenza Artificiale, che sono già molto diffusi (non solo per i dirigenti aziendali ma anche per le celebrità e persino i Presidenti degli Stati Uniti) e possono essere molto difficili da individuare.

Gli esperti di Intelligenza Artificiale prevedono che i contenuti generati dall'AI alla fine saranno indistinguibili da quelli creati dall'uomo. Si prospetta quindi uno scenario, tutt’altro che distopico, in cui campagne di vishing concettualmente simili a quella dell’esempio verranno condotte su larga scala utilizzando la generazione automatizzata e in tempo reale di modelli di testo e testo-voce.

Lo scenario dell'autenticazione biometrica

La biometria ha cambiato in meglio la cybersecurity semplificando e rendendo più efficace il processo di identificazione dell’utente. Il problema che gli esperti di security stanno cercando di gestire è che i sistemi di autenticazione biometrica possono essere ingannati dagli attaccanti che utilizzano l'intelligenza artificiale generativa con l’obiettivo di compromettere le identità e accedere a un ambiente protetto.

Lazarovitz cita uno studio dell'Università di Tel Aviv in cui i ricercatori sono riusciti, usando un modello di intelligenza artificiale chiamato GAN (Generative Adversarial Networks), a creare una "master face" che potrebbe essere utilizzata per bypassare la maggior parte dei sistemi di riconoscimento facciale. In sostanza l’AI ha testato e ottimizzato delle immagini vettoriali cercando di abbinarle alle immagini facciali archiviate in un grande repository.

Il risultato sono nove “master face” che corrispondono a oltre il 60% dei volti presenti nel database. In altre parole, gli attaccanti avrebbero una probabilità del 60% di aggirare con successo il processo di autenticazione mediante riconoscimento facciale per compromettere un'identità.

L’esperto di Cyberark ricorda che i modelli di Intelligenza Artificiale generativa sono in circolazione da anni. Il problema di oggi quindi non è la loro esistenza, ma la velocità alla quale possono imparare, che aumenta esponenzialmente di continuo. Ciò comporta che le AI generative continueranno a migliorare nella creazione di deep fake realistici, malware e altre minacce dall’alto potenziale dannoso.

Lo scenario del malware polimorfo

La base degli impianti di attacco moderni sono le soluzioni per eludere i controlli antimalware sempre più sofisticati. Per questo motivo si teme l’impiego di ChatGPT per la generazione di codice, e per lo stesso motivo sono nati tempo addietro i malware polimorfi. Si tratta di un tipo di malware particolarmente insidioso perché ostacola la rilevazione sfruttando un motore polimorfo e una routine di cifratura al suo interno che generano copie differenti di sé man mano che si propagano all’interno di un ambiente.

Questa loro natura ha portato Lazarovitz a studiare uno scenario di associazione con l’AI. L’esperto ricorda che quando impiegata negli attacchi cyber, l'Intelligenza Artificiale è efficace nelle prime fasi della catena di attacco, ossia la ricognizione, il malware e l'accesso iniziale. Quello che non è chiaro è se l’AI possa essere altrettanto efficace nella generazione di TTP (Tattiche, Tecniche e Procedure) da attuare una volta che gli attaccanti sono all’interno di una rete target e devono fare l’escalation dei privilegi e attuare gli spostarsi laterali.

I CyberArk Labs reputano che l’efficacia in questa seconda fase possa aumentare finanche a consentire l’evasione della difesa basata sulle TTP di MITRE, affidando all’AI un malware polimorfico. Per verificare questa ipotesi gli esperti hanno sperimentato l’impiego di ChatGPT per creare malware polimorfico. In particolare, hanno chiesto a ChatGPT di generare un infostealer. Per dirla con le parole di Lazarovitz, “ChatGPT è uno sviluppatore entusiasta ma ingenuo”, nel senso che scrive codice rapidamente ma manca dettagli critici e contesto. Tuttavia, il risultato migliorerà con il progredire dei modelli di Intelligenza Artificiale.

Le tecniche di attacco con le AI pensate da CyberArk, mappate sul framework MITRE ATT&CK for Enterprise

Le tecniche di attacco con le AI pensate da CyberArk, mappate sul framework MITRE ATT&CK for Enterprise

Conclusioni

Quello che tiene a sottolineare Lazarovitz in conclusione è che l'AI ha già avuto e continuerà ad avere un impatto enorme sul panorama delle minacce. Le identità rimangono i principali obiettivi di attacco, per questo è necessario evolvere la prevenzione, applicando il principio dei privilegi minimi o l'accesso condizionale alle risorse sia locali che di rete.

Nel frattempo non bisogna dimenticare che l'IA è anche uno strumento di difesa molto potente che può permettere ai difensori di tenersi un passo avanti rispetto agli attaccanti, oltre a semplificare e automatizzare la difesa.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici