La Shadow AI sfugge al controllo: il 90% dell'uso è invisibile alle aziende

Il 90% delle attività AI in azienda è fuori controllo. Account personali e tool non monitorati espongono dati sensibili a rischi nascosti.

Le aziende non hanno visibilità sull'89% dell'utilizzo dell'AI da parte dei propri dipendenti, nonostante le policy di sicurezza attive; il 71% delle connessioni agli strumenti GenAI avviene utilizzando account personali e il 58% di quelle che passano per account aziendali non fanno uso di Single-Sign On (SSO).

Quelli elencati sono solo alcuni dei dati raccolti nell’Enterprise GenAI Security Report 2025 di LayerX Security, che fornisce una prospettiva unica sul modo in cui i dipendenti aziendali interagiscono con gli strumenti di GenAI. L'analisi, che è un punto di riferimento per misurare l’impatto della Shadow AI, si concentra sulle modalità di utilizzo, sugli utenti coinvolti e sui rischi per la sicurezza, evidenziando molti problemi connessi all'uso di strumenti AI non ufficialmente riconosciuti dalle imprese.

Il risultato è una mancanza di controllo pressoché totale dell’uso degli strumenti di AI: le cifre riportate sopra sono di per sé più che sufficienti per evidenziare che la maggior parte delle aziende non sa chi sta utilizzando strumenti AI e quali dati vengano condivisi nelle conversazioni con le AI.

Uno degli aspetti più critici riguarda il modo in cui i dati aziendali vengono immessi nei modelli di intelligenza artificiale: secondo il report circa il 18% degli utenti incolla i dati negli strumenti GenAI, e di questi circa il 50% sono informazioni aziendali. Sebbene solo l'1% degli utenti carichi file nei sistemi AI, chi lo fa tende a ripetere l'operazione più volte al giorno, con un alto rischio di perdita di dati aziendali.

Uno degli aspetti più critici riguarda il modo in cui i dati aziendali vengono immessi nei modelli di intelligenza artificiale: secondo il report circa il 18% degli utenti incolla i dati negli strumenti GenAI, e di questi circa il 50% sono informazioni aziendali. Sebbene solo l'1% degli utenti carichi file nei sistemi AI, chi lo fa tende a ripetere l'operazione più volte al giorno, con un alto rischio di perdita di dati aziendali.

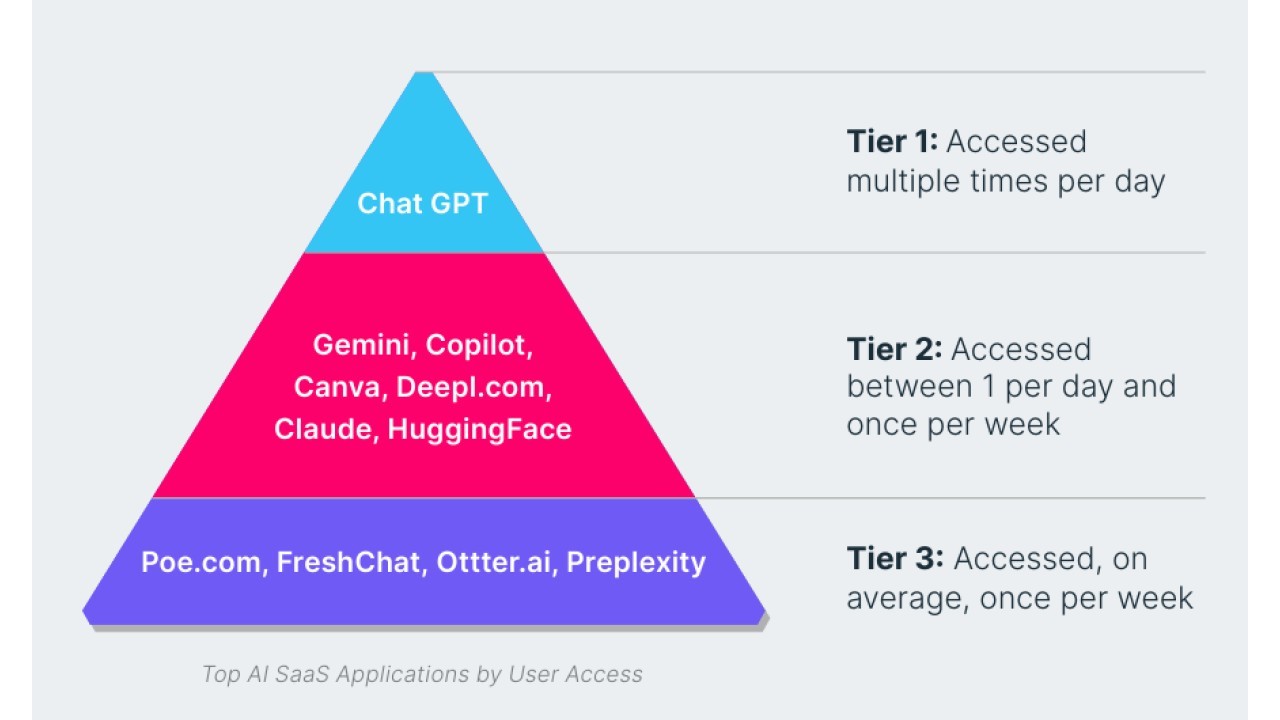

A dare da pensare sono anche i canali usati. Notoriamente il mercato delle applicazioni AI è dominato da pochi strumenti molto noti, con ChatGPT che da solo rappresenta oltre il 50% dell'utilizzo aziendale. Tuttavia, oltre alle piattaforme principali esiste una vasta gamma di applicazioni AI meno conosciute che sfuggono al controllo delle imprese. I dati del report esplicano che oltre l'85% del traffico AI aziendale si concentra nei primi cinque strumenti più utilizzati, ma sporadicamente vengono usate centinaia di altre applicazioni AI senza monitoraggio, aumentando ulteriormente i rischi di sicurezza.

Un'altra problematica riguarda le estensioni AI per browser, che rappresentano una porta d'accesso alternativa per la fuga incontrollata di dati aziendali. Circa il 20% degli utenti aziendali ha installato almeno un'estensione AI nel proprio browser; quasi la metà di questi ne utilizza più di una. Il 58% delle estensioni AI ha permessi di accesso classificati come alti o critici, ossia consentono di monitorare le attività di navigazione, di leggere contenuti delle pagine web e di accedere a cookie e altri dati utente. Inoltre, il 5,6% delle estensioni AI è stato identificato come potenzialmente dannoso in quanto ha la capacità di sottrarre informazioni sensibili.

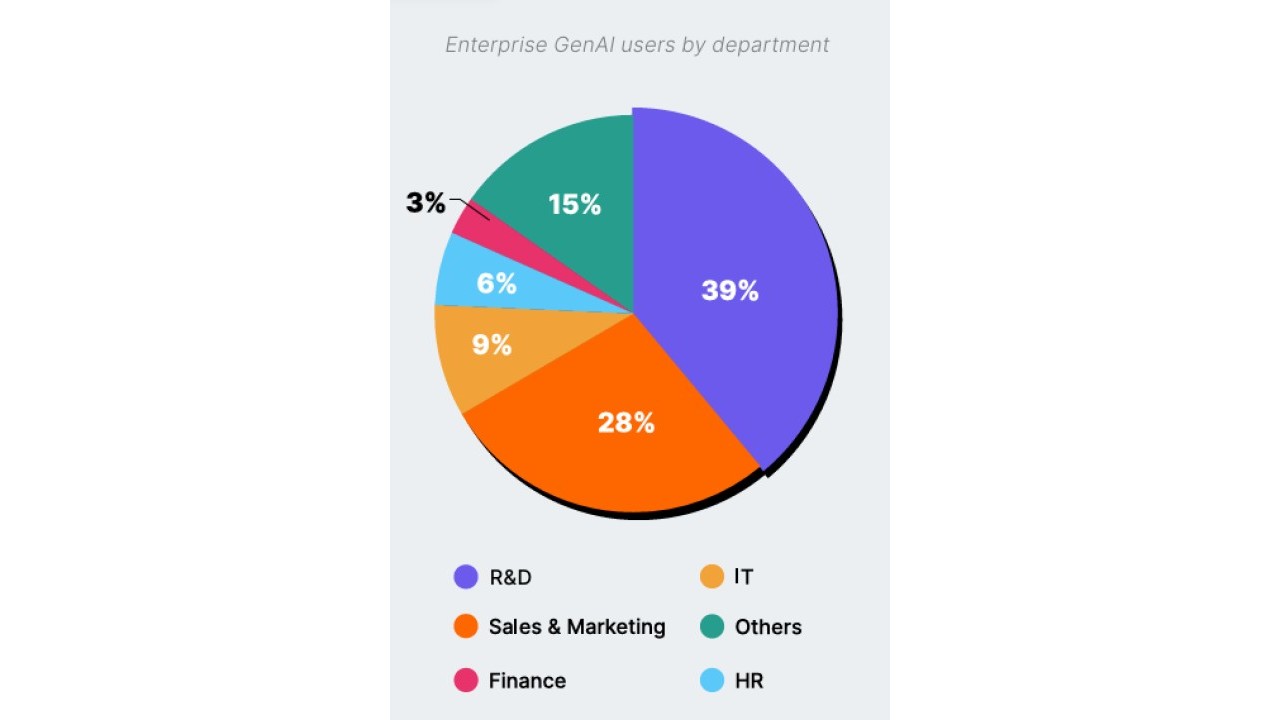

L'analisi mostra poi una distribuzione eterogenea dell'uso di GenAI nei vari dipartimenti aziendali. Gli sviluppatori software rappresentano il gruppo più numeroso tra gli utilizzatori di AI, con il 39% degli utenti regolari provenienti dall'area Ricerca & Sviluppo. Segue il settore vendite e marketing con il 28%, mentre IT, HR e finanza ne fanno un uso significativamente inferiore. Questo riflette le attuali tendenze di mercato, in cui gli strumenti di GenAI vengono sfruttati soprattutto per la generazione di codice, per la creazione di contenuti e per l'analisi dei dati di vendita.

Come alzare la sicurezza

I risultati del report evidenziano la necessità per le aziende di adottare strategie di sicurezza mirate per la gestione dell'uso della GenAI. Tra le raccomandazioni fornite agli esperti c’è la mappatura dell'utilizzo dell'AI all'interno dell'organizzazione per comprendere chi la usa, con quali strumenti e per quali finalità. Inoltre, viene suggerito di limitare l'uso di account personali per l'accesso a strumenti AI e di imporre l'uso dell'SSO per garantire maggiore controllo e tracciabilità.

Un'altra misura fondamentale è la sensibilizzazione dei dipendenti sui rischi associati alla condivisione di dati con strumenti AI, mediante campagne di formazione e messaggi di avviso ogni volta che un utente accede a un'applicazione AI. Per limitare la potenziale perdita di dati, è consigliato impedire l'upload di informazioni sensibili, specialmente tramite copia/incolla o upload di file. Infine, il report sottolinea l'importanza di monitorare e controllare le estensioni AI installate nei browser aziendali, perché rappresentano una minaccia spesso trascurata.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici